【搜索问答剧场 5】“百度蜘蛛”全面解析

在微博里,38岁的他更关注互联网、热点新闻、军事和手机。“微博控”这个几年前红火的潮词在他身上至今也不过......

由于用户对手机的依赖愈加严重,随之而来的是大量的系统垃圾,以及由此导致的内存不够用、手机运行卡顿等使用......

阿里云机器翻译是阿里语言服务发布的在线翻译服务,致力于帮助用户跨越语言鸿沟。它依托海量的互联网数据资源......

当一个产品经理在规划产品中的语音功能时,在大多数情况下,他需要的不仅仅是语音识别,还需要其背后的智能交......

6月5日世界环境日,腾讯电脑管家、腾讯手机管家正式上线“清理+”公益平台,并携手阿拉善SEE基金会、腾讯公益......

6月6日 BAT 日报讯: 1.百度、腾讯和京东对易车网进行战略投资:三家公司各自投资5000万美元,百度、腾讯和......

支付方式之争:扫码支付与NFC从争夺到结合 以支付宝和微信支付为代表的扫码支付,是目前国内移动支付的主流方......

尽管闪付和扫码支付从暗战到融合,但这并不意味着移动支付领域战火的平息,对于支付宝和微信支付而言,双方的......

6月7日消息,腾讯北京分公司总经理刘勇在本届中国互联网企业发展论坛上发表主题为“互联网+”时代的创业创新的......

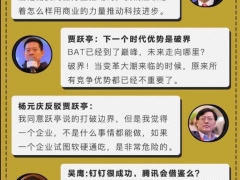

在BAT三座大山之外,有不少公司曾被视为中国互联网的第四极,被寄托了挑战BAT的资格,这里头不仅仅只有小米,......